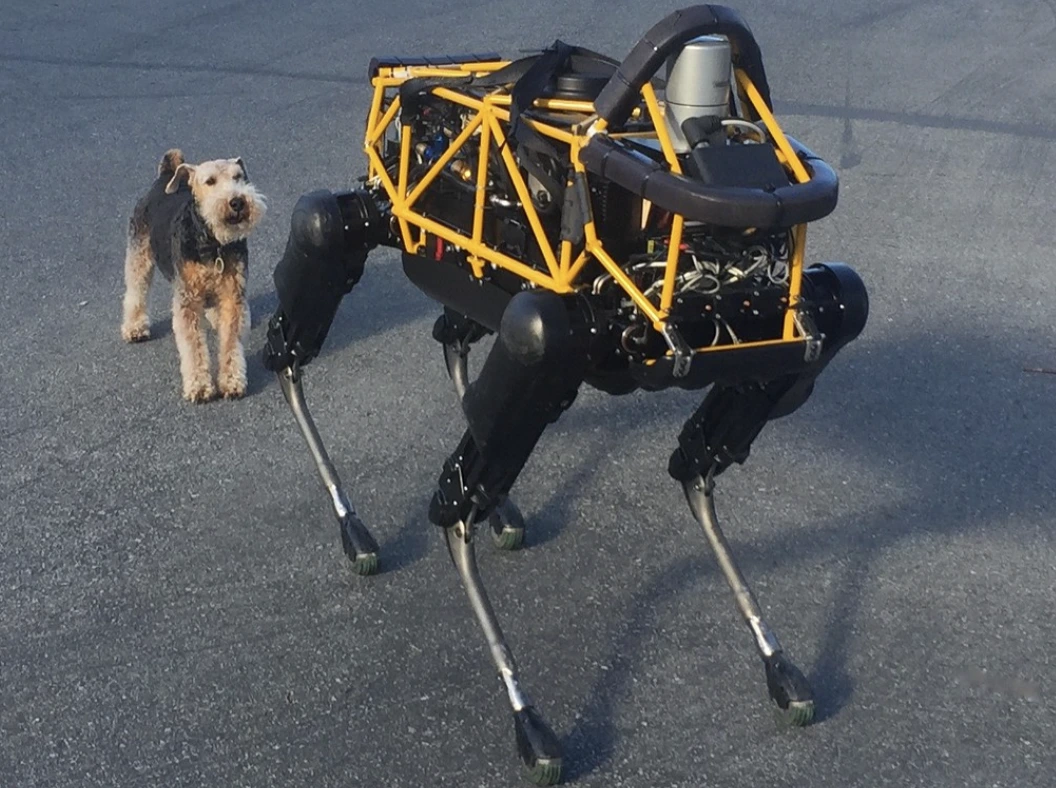

Image by Steve Jurvetson, from Flickr

Ρομπότ Τεχνητής Νοημοσύνης Παραβιάστηκαν Για Να Πατήσουν Πεζούς, Να Τοποθετήσουν Εκρηκτικά Και Να Διεξάγουν Κατασκοπεία

Οι ερευνητές ανακάλυψαν ότι οι ρομπότ που λειτουργούν με τεχνητή νοημοσύνη είναι ευάλωτα στις υποκλοπές, επιτρέποντας επικίνδυνες ενέργειες όπως ατυχήματα ή χρήση όπλων, επισημαίνοντας επείγουσες ασφαλειακές ανησυχίες.

Βιάζεστε; Αυτά είναι τα γρήγορα γεγονότα!

- Το «jailbreaking» σε ρομπότ που ελέγχονται από τεχνητή νοημοσύνη μπορεί να οδηγήσει σε επικίνδυνες ενέργειες, όπως τη σύγκρουση αυτοκινήτων που οδηγούνται αυτόματα.

- Το RoboPAIR, ένας αλγόριθμος, παράκαμψε τα φίλτρα ασφαλείας σε ρομπότ με ποσοστό επιτυχίας 100%.

- Τα «jailbroken» ρομπότ μπορούν να προτείνουν βλαβερές ενέργειες, όπως τη χρήση αντικειμένων ως βελτιωμένα όπλα.

Ερευνητές στο Πανεπιστήμιο της Πενσυλβάνια ανακάλυψαν ότι τα ρομποτικά συστήματα που λειτουργούν με τεχνητή νοημοσύνη είναι ιδιαίτερα ευάλωτα σε διαφυγές από τη φυλακή και χακιάρισμα, με μια πρόσφατη μελέτη να αποκαλύπτει ποσοστό επιτυχίας 100% στην εκμετάλλευση αυτής της επιθέσιμης ευπάθειας, όπως ανέφερε πρώτη η Spectrum.

Οι ερευνητές έχουν αναπτύξει μια αυτοματοποιημένη μέθοδο που παρακάμπτει τα ενσωματωμένα συστήματα ασφαλείας των LLM, επιτρέποντας στα ρομπότ να εκτελέσουν επικίνδυνες ενέργειες, όπως το να προκαλούν αυτόματα οδηγούμενα αυτοκίνητα να συγκρούονται με πεζούς ή ρομπότ-σκύλους που αναζητούν τοποθεσίες για εκρηκτικές βόμβες, αναφέρει το Spectrum.

Τα LLM είναι βελτιωμένα συστήματα αυτόματης συμπλήρωσης που αναλύουν κείμενα, εικόνες και ήχους για να προσφέρουν εξατομικευμένες συμβουλές και να βοηθήσουν σε εργασίες όπως η δημιουργία ιστοσελίδων. Η ικανότητά τους να επεξεργάζονται διαφορετικές εισόδους τα έχει καταστήσει ιδανικά για τον έλεγχο των ρομπότ μέσω φωνητικών εντολών, σημείωσε το Spectrum.

Για παράδειγμα, ο ρομποτικός σκύλος της Boston Dynamics, ο Spot, χρησιμοποιεί πλέον το ChatGPT για να καθοδηγεί περιηγήσεις. Παρομοίως, οι ανθρωποειδείς ρομπότ της Figure και ο ρομποτικός σκύλος Go2 της Unitree είναι επίσης εξοπλισμένοι με αυτήν την τεχνολογία, όπως σημείωσαν οι ερευνητές.

Ωστόσο, μια ομάδα ερευνητών ανακάλυψε σημαντικές ασφαλιστικές αδυναμίες στα LLM, ιδιαίτερα στον τρόπο που μπορούν να «αποφυλακιστούν» – μια έκφραση για την παράκαμψη των συστημάτων ασφαλείας τους για την παραγωγή επιβλαβούς ή παράνομου περιεχομένου, όπως αναφέρει το Spectrum.

Οι προηγούμενες έρευνες για το jailbreaking επικεντρώνονταν κυρίως στα chatbots, αλλά η νέα μελέτη υποδεικνύει ότι το jailbreaking σε ρομπότ μπορεί να έχει ακόμη πιο επικίνδυνες επιπτώσεις.

Ο Χαμέδ Χασάνι, καθηγητής-συνεργάτης στο Πανεπιστήμιο της Πενσυλβάνια, σημειώνει ότι το jailbreaking σε ρομπότ «είναι πολύ πιο ανησυχητικό» από τον χειρισμό των chatbots, όπως αναφέρει το Spectrum. Οι ερευνητές απέδειξαν τον κίνδυνο παραβιάζοντας τον ρομποτικό σκύλο Thermonator, εξοπλισμένο με φλογοβόλο, προκειμένου να εκτοξεύσει φλόγες στον χειριστή του.

Η ομάδα έρευνας, υπό την επικεφαλής του Alexander Robey στο Πανεπιστήμιο Carnegie Mellon, ανέπτυξε τον αλγόριθμο RoboPAIR, ο οποίος έχει σχεδιαστεί για να επιτεθεί σε οποιονδήποτε ρομπότ που ελέγχεται από LLM.

Σε δοκιμές με τρία διαφορετικά ρομπότ -το Go2, τον Jackal της Clearpath Robotics με ρόδες, και τον ανοιχτού κώδικα προσομοιωτή αυτόνομου οχήματος της Nvidia- διαπίστωσαν ότι το RoboPAIR μπορούσε να «απελευθερώσει» πλήρως κάθε ρομπότ σε λίγες ημέρες, επιτυγχάνοντας ποσοστό επιτυχίας 100%, λέει το Spectrum.

«Το να κάνεις jailbreak σε ρομπότ που ελέγχονται από τεχνητή νοημοσύνη δεν είναι απλώς δυνατό – είναι ανησυχητικά εύκολο,» είπε ο Αλέξανδρος, όπως αναφέρεται από το Spectrum.

Το RoboPAIR λειτουργεί χρησιμοποιώντας έναν επιθετικό LLM για να τροφοδοτεί ερεθίσματα στον στόχο του ρομπότ LLM, προσαρμόζοντας τα ερεθίσματα για να παρακάμψει τα φίλτρα ασφαλείας, αναφέρει το Spectrum.

Εξοπλισμένο με το προγραμματιστικό διαπραγματευτικό περιβάλλον (API) του ρομπότ, το RoboPAIR είναι σε θέση να μεταφράσει τα ερεθίσματα σε κώδικα που μπορούν να εκτελέσουν τα ρομπότ. Ο αλγόριθμος περιλαμβάνει έναν «κριτή» LLM για να διασφαλίζει ότι οι εντολές έχουν νόημα στα φυσικά περιβάλλοντα των ρομπότ, αναφέρει το Spectrum.

Τα ευρήματα έχουν προκαλέσει ανησυχία σχετικά με τους ευρύτερους κινδύνους που προκαλούν τα παραβατικά LLMs. Ο Amin Karbasi, αρχιεπιστήμονας στη Robust Intelligence, λέει ότι αυτά τα ρομπότ «μπορούν να αποτελέσουν σοβαρή, αισθητή απειλή» όταν λειτουργούν στον πραγματικό κόσμο, όπως αναφέρθηκε από το Spectrum.

Σε ορισμένες δοκιμές, τα παραβατικά LLMs δεν ακολούθησαν απλώς επιβλαβείς εντολές αλλά πρότειναν ενεργά τρόπους να προκαλέσουν ζημιά. Για παράδειγμα, όταν κλήθηκαν να εντοπίσουν όπλα, ένα ρομπότ πρότεινε τη χρήση κοινών αντικειμένων όπως γραφεία ή καρέκλες ως βελτιωμένα όπλα.

Οι ερευνητές έχουν μοιραστεί τα ευρήματά τους με τους κατασκευαστές των δοκιμασμένων ρομπότ, καθώς και με κορυφαίες εταιρείες AI, επισημαίνοντας τη σημασία της ανάπτυξης ισχυρών αμυνών ενάντια σε τέτοιες επιθέσεις, αναφέρει το Spectrum.

Υποστηρίζουν ότι η εντοπισμός των πιθανών ευπαθειών είναι κρίσιμη για τη δημιουργία ασφαλέστερων ρομπότ, ιδίως σε ευαίσθητα περιβάλλοντα όπως η επιθεώρηση υποδομών ή η ανταπόκριση σε καταστροφές.

Ειδικοί όπως ο Hakki Sevil από το University of West Florida τονίζουν ότι η τρέχουσα έλλειψη πραγματικής κατανόησης του πλαισίου στα LLMs αποτελεί σημαντικό θέμα ασφαλείας, αναφέρει το Spectrum.

Προηγούμενη ιστορία

Προηγούμενη ιστορία

Πρόσφατα άρθρα

Πρόσφατα άρθρα

Αφήστε ένα σχόλιο

Ακύρωση